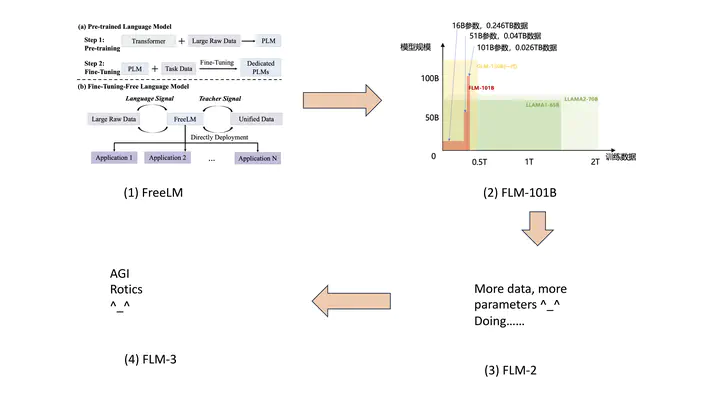

FLM 系列大模型

FLM 是北京智源人工智能研究院认知模型团队(Cofe-AI) 联合清华大学、中科院计算所、南洋理工大学和电子科技大学等单位共同研制的语言大模型。项目目标是研制低成本的全面开源、效果优秀的大模型。FLM 系列目前已经演化到第二代 FLM-2 (Tele-FLM)。

1. FLM-2 (aka Tele-FLM)

1.1 基础模型

1.1.1 世界上最大的单体大模型

2024年智源大会和世界人工智能大会,智源研究院和中国电信再次发布全球最大的大模型,Tele-FLM-1T,模型参数已经开源,期望为社区未来训练万亿大模型提供一个优秀的初始化参数。

- Tele-FLM-1T 技术报告: https://arxiv.org/pdf/2407.02783

- 模型参数: https://huggingface.co/CofeAI/Tele-FLM-1T

1.1.2 低碳大模型

FLM-2 (aka Tele-FLM),是智源和电信联合研发的全球首个低碳、高性能的开源多语言大模型,4月27日在中关村论坛年会未来人工智能先锋论坛上正式发布。FLM 系列大模型解决了大模型超参敏感、成本极高的关键问题,实现大模型训练零调整,是全球首个实现了低碳预训练的大模型。Tele-FLM 在基础模型评测中取得了领先的效果,BPB loss 指标在英文上优于Llama2-70B和 Llama3-8B,在中文上优于Qwen1.5-72B;对话模型 Tele-FLM-Chat 性能已经超过GPT-3.5。为促进大模型社区的发展,Tele-FLM 的模型权重、核心技术和训练细节等已全面开源。

- Tele-FLM 技术报告: https://arxiv.org/abs/2404.16645

- 模型参数: https://huggingface.co/CofeAI/Tele-FLM

- 核心技术-生长技术: https://github.com/cofe-ai/MSG

- 核心技术-损失预测: https://github.com/cofe-ai/Mu-scaling

1.2 Instruct 模型

FLM-2-52B-Instruct 是基于Tele-FLM-52B基座模型进行指令微调获得的指令对话模型。

- FLM-2-52B-Instruct 模型参数: https://huggingface.co/CofeAI/FLM-2-52B-Instruct-2407

1.2.1 数据

我们专注于通过监督微调(SFT),使基座模型获得中文对话能力,以收集的100万条开源指令作为全集,并在不同的采样子集上进行微调,研究SFT数据对下游任务表现的影响。尽管SFT数据广泛涵盖了对话、数学、代码、推理、语言理解、头脑风暴、文本生成等多个领域,但是使用全集进行微调并不是SFT的最优解。通过对不同采样策略的实验,基于一个3万条数据的子集获得了最优结果。这3万条数据由两部分构成:

- 25,000条被聚类模型标记为“数学”的数据,包括数学题目与对应的步骤、答案(主要是小学到初中难度),以及关于数学概念的问答;

- 5,000条代码和多轮对话数据。

为了提升数据质量,我们使用Tele-FLM-52B基座模型计算每个回答的困惑度(Perplexity)。上述3万条数据是从更大的数据集样本中,在各个数据集中通过不同阈值,筛选出最低困惑度的数据。实验结果表明,选取低困惑度的数据有助于提升下游任务性能。

1.2.2 训练设置

训练过程中,将batch size设定为128,学习率设定为1.35e-5,总共训练4个epoch。学习率通过线性衰减,在第4个epoch末尾下降至5e-10。将weight decay设置为0.1,dropout设置为0。选取第4个epoch末尾的checkpoint进行评测和发布。

1.2.3 模型评测

基于AlignBench评测平台对中文对话能力进行评测。AlignBench包含8大类任务,其中数学计算、逻辑推理两项衡量模型的中文推理能力,基本任务、中文理解、综合问答、文本写作、角色扮演、专业能力六项衡量模型的中文语言能力。使用平台提供的CritiqueLLM服务对FLM-2-52B-Instruct模型的回答和参考答案进行打分。CritiqueLLM的打分与GPT-4具有较好的一致性。

在下表中,GPT系列和ChatGLM-Turbo对比结果显示,FLM-2-52B-Instruct 总体均分显著高于GPT-3.5,并达到GPT-4-0613的90%。

| 模型 | 均分 | 数学计算 | 逻辑推理 | 基本任务 | 中文理解 | 综合问答 | 文本写作 | 角色扮演 | 专业能力 |

|---|---|---|---|---|---|---|---|---|---|

| gpt-4-1106-preview | 7.58 | 7.39 | 6.83 | 7.69 | 7.07 | 8.66 | 8.23 | 8.08 | 8.55 |

| gpt-4-0613 | 6.83 | 6.33 | 5.15 | 7.16 | 6.76 | 7.26 | 7.31 | 7.48 | 7.56 |

| gpt-3.5-turbo-0613 | 5.68 | 4.90 | 4.79 | 6.01 | 5.60 | 6.97 | 7.27 | 6.98 | 6.29 |

| chatglm-turbo | 6.36 | 4.88 | 5.09 | 7.50 | 7.03 | 8.45 | 8.05 | 7.67 | 7.70 |

| FLM-2-52B-Instruct-2407 | 6.23 | 3.79 | 5.15 | 7.69 | 7.86 | 8.45 | 8.17 | 7.88 | 7.80 |

在表中可以观察到,在参与对比的模型中,FLM-2-52B-Instruct在基本任务和中文理解两个子项上取得最优,而在逻辑推理、综合问答、文本写作、角色扮演、专业能力等五个子项上位列第二,这说明对话模型具有先进的对话能力。同时,模型的数学和推理能力与GPT-4-1106仍然有明显差距,这是未来的改进方向之一。值得注意的是,SFT数据几乎只包含数学和推理相关的指令和对话,却在数学和推理以外的任务上取得了领先的效果。这表明SFT能够有效激发基座模型的知识和语言能力,并且达成这一目的所需要的训练数据量较少。这与SFT中一个“少即是多”的流行观点相吻合。然而,“少即是多”只对通用语言能力生效,而对于数学、推理任务,3万条领域内数据可能仍然是不足的。

2. FLM-101B

FLM-101B 继承了FreeLM 的语言结构,并采用了生长策略(Growth Strategy,算法名称为MSG)将成本降低了超过70%,同时采用损失预测技术确定最优超参。FLM-101B 是一重要里程碑,其不仅确定了各个子技术的可行性,更在系统层面上将其成功实现。关于FLM-101B 和 MSG的关系,我们认为是 GPT-3 和 Transformer的关系,不是简单的扩大规模,而是一种系统层面的首次成功实现。

详细资料可参考知乎专栏-FLM-101B: 如何用10万美元预算训练一个千亿模型

3. FreeLM

FreeLM 为第0代,其目标为确定将相关的知识学习阶段融合到语言模型训练阶段的可行性验证。

详细资料可参考知乎专栏-大模型训练新范式:免微调生成式语言大模型

4. 大模型研发理念

关于大模型研发。团队的理念是:

- 系统能力和科研能力缺一不可。

- 没有系统能力,就无法研发大模型,否则无法控制成本。

- 没有科研能力,只能亦步亦趋,在大模型领跑者选择闭源的情况下,无法进一步突破。

欢迎系统能力和科研能力都强的研究者联系我!